로그인을 하시면 메디칼타임즈의

로그인을 하시면 메디칼타임즈의다양한 연관서비스를 이용하실 수 있습니다. 가입 시 등록한 정보를 입력해주세요.

개인정보 보호를 위한 비밀번호 변경안내

주기적인 비밀번호 변경으로 개인정보를 지켜주세요.

개인정보 보호를 위한 비밀번호 변경안내

주기적인 비밀번호 변경으로 개인정보를 지켜주세요.안전한 개인정보 보호를 위해 3개월마다 비밀번호를 변경해주세요. ※ 비밀번호는 마이페이지에서도 변경 가능합니다.

- 정책

- 제도・법률

[Prologue] 질문에서 통찰로, 통찰에서 기준으로

-

가

-

유소영 교수(서울아산병원/울산의대)

[의료 AI 윤리∙정책 Lab] 가드레일(The Guardrails): 회색지대에서 길을 묻다

[Prologue] 질문에서 통찰로, 통찰에서 기준으로— 우리 사회가 설계하는 윤리와 정책

"당신은 지극히 건강합니다. 어떠한 증상도 없죠. 그런데 인공지능(AI)이 당신의 흉부 엑스레이 한 장을 보더니 단언합니다. '당신은 5년 안에 심부전으로 사망할 확률이 85%입니다.' 의사인 당신은 이 기계의 예언을 환자에게 통보하시겠습니까? 아니면 '통계적 확률일 뿐'이라며 차트를 덮으시겠습니까?"

이 질문은 더 이상 가상이 아닙니다.

2024년 《Nature Communications》에 발표된 연구(Christensen et al., 2024)에 따르면, AI는 숙련된 전문의조차 '완벽하게 정상'이라 판독한 흉부 CT 영상 데이터에서 인간의 눈으로는 결코 포착할 수 없는 미세한 신호들을 읽어냈습니다. AI는 이 '보이지 않는 패턴'을 근거로, 현재 증상이 없는 환자의 전반적인 사망 위험을 약 80% 이상의 정확도(C-index 0.77~0.83)로 예견하는 수준에 도달했습니다.

기술은 이제 단순히 인각의 시력을 보조하는 도구가 아닙니다,

AI는 인간이 인지하지 못하는 생물학적 미래를 먼저 포착하는, 일종의 '준 주체적' 존재로 진화하고 있습니다. 만약 이 예측 덕분에 환자가 조기 진단을 받아 건강을 되찾는다면 이는 '축복 같은 진단'이겠지만, 반대로 그 예측이 단 1%라도 틀린 것이라면 어떨까요? 기계의 확신을 신뢰한 결과, 환자가 남은 삶을 공포와 절망 속에서 보냈다면 그 책임은 누구의 몫이어야 할까요?

기술은 앞서가고, 규범은 따라오지 못한다

문제는 예측 AI에만 국한되지 않습니다.

최근 의료 현장에 깊숙이 침투한 생성형 AI는 그럴듯한 문장으로 거짓 의학 정보를 지어내는 '임상적 환각(Clinical Hallucination)'이라는 치명적인 결함을 드러내고 있습니다. 2024년 《NEJM AI》와 《JAMA》에 보고된 사례에 따르면, 최신 의료용 대형언어모델(LLM)은 완벽한 의학 용어와 논리를 구사하며 존재하지 않는 문헌을 인용하거나, 임상 가이드라인에 어긋나는 약물 처방 권고를 제시하기도 했습니다. 특히 복잡한 환자 케이스에서 AI가 내놓은 오답은 전문가조차 식별하기 어려운 '논리적 오류'를 포함하고 있었습니다.

만약 AI가 작성한 의뢰서에 교묘하게 섞인 환각을 의료진이 미처 거르지 못한 채 서명(Signing)하여 사고가 발생한다면 그 책임은 누구에게 있을까요? 법은 이에 대해 명확한 답을 제시합니다. '박학한 중재자 원칙(Learned Intermediary Doctrine)'에 따르면, AI는 법적 주체가 될 수 없으며, 모든 책임은 그 도구를 선택하고 검증할 최종 의무를 지닌 인간, 즉 의료진에게 귀속됩니다. "AI가 그렇게 말했다"는 항변은 법정에서 결코 방패가 되지 못합니다.

반대의 상황은 더욱 날카롭습니다.

AI가 99.9%의 확률로 경고한 위험을 의료진이 '임상적 직관'으로 무시했다가 사고가 난다면 어떻게 될까요? AI는 아직 법적 의미의 표준 치료(Standard of Care)는 아닙니다.

그러나 임상 가이드라인과 의사결정 흐름 속에 AI가 점차 통합되면서, 의료진에게 요구되는 주의의무의 기준 자체가 상향 조정되는 임계점에 다가서고 있습니다.

합리적 근거 없이 AI의 정교한 권고를 배제해 환자에게 손해가 발생한다면, 이는 과거보다 훨씬 무거운 법적 책임으로 이어질 가능성이 큽니다.

사고실험(Thought Experiment): 우리의 통찰이 내일의 상식이 되는 공간

오늘날 의료 AI는 기존의 법·윤리 체계가 충분히 도달하지 못한 '규범적 공백(Normative Gap)' 위에 서 있습니다.

딥러닝 기반 의료 AI가 고도화될수록, 모델의 예측 성능은 비약적으로 향상되는 반면 그 판단 근거가 임상적·법적·윤리적 책임을 감당할 만큼 충분히 설명되지 않는 경우가 많습니다. 이로 인해 결과에 대한 책임은 여전히 인간에게 집중되지만, 판단의 근거는 기계 내부에 머무는 구조적 불균형이 발생합니다. 이것이 바로 '책임의 공백(Responsibility Gap)'입니다.

저는 기술 혁신과 규범이 맞닿는 접점에서 보건의료 데이터 및 AI 윤리 정책의 균형점을 모색해 온 전문가입니다. 오랜 시간 현장의 목소리를 정책과 연결하며 실무적인 거버넌스 체계를 정립해 왔습니다. 현장에서 제가 반복해서 확인한 사실은 분명합니다. 실제 사용자의 통찰과 사회적 수용성이 담기지 않은 정책은, 결코 현장에서 작동하지 않는다는 점입니다.

그래서 저는 이 [의료 AI 랩]을 통해, 아직 제도화되지 않은 의료 AI의 미래를 선제적으로 설계하는 '윤리·정책 인큐베이터'를 시작하려 합니다. 우리가 함께 수행할 사고실험(Thought Experiment)은 정답을 맞히는 시험이 아닙니다. 기술과 인간이 맞닿는 회색지대에서, 사용자와 사회의 시각에서 실제로 작동 가능한 윤리적·정책적 가드레일을 설계하는 실전 과정입니다.

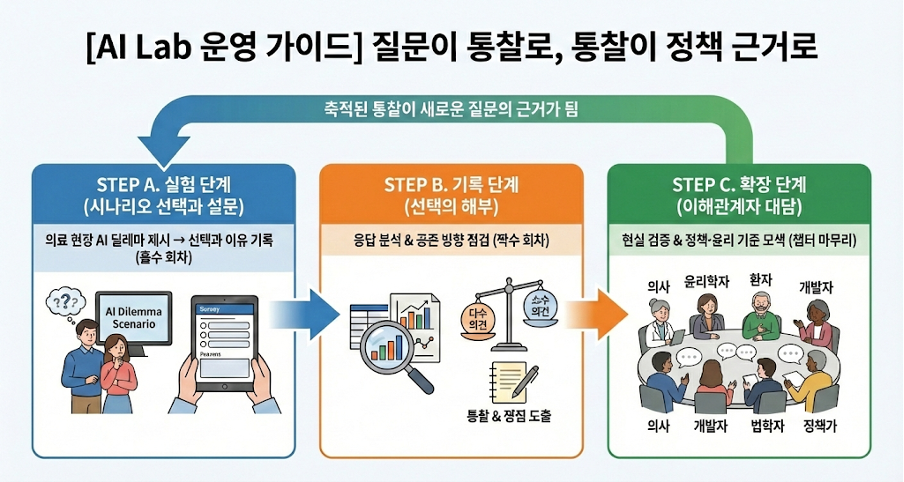

[AI Lab 운영 가이드] 사유의 흐름이 정책의 밑그림이 되기까지

이 연재의 목적은 지식이나 정답을 제시하는 데 있지 않습니다.

대신 질문이 통찰로 이어지고, 통찰이 다시 윤리·정책의 근거로 축적되는 순환 구조를 만드는 데 있습니다.

- STEP A. 실험 단계 (Experiment Phase): 시나리오 선택과 설문 (홀수 회차)

-의료 현장에서 마주하는 현실적인 AI 딜레마 시나리오를 제시합니다. 독자 여러분은 설문에서 [선택지]를 결정하고 그에 대한 [이유]를 기록합니다.

- STEP B. 기록 단계 (Insight Phase): 선택의 해부 (짝수 회차)

- -짝수 회차마다 지난 호 설문 응답과 근거를 정밀하게 분석합니다.

- -다수 의견의 논리와 소수 의견이 던지는 경고를 함께 읽어내며, 우리가 지향해야 할 공존의 방향과 기준을 점검합니다.

- STEP C. 확장 단계 (The Dialogue): 이해관계자 대담 [한 챕터 마무리 시]

- -한 챕터가 마무리될 때마다 전문가, 현장 실무자, 환자/보호자, 정책 담당자 등 이해관계자와의 대담을 진행합니다.

- -STEP B에서 도출된 분석과 쟁점을 현실에 대입해 검증·보완하고, 실행 가능한 윤리 기준과 정책·제도 개선 방향으로 확장합니다.

관련기사

- AI가 병리 전문의 수작업 대신…"암 진단 25% 가속" 2026-01-14 12:03:37

- 기술력 뽐내는 코어라인소프트…FDA 승인 AI 기기 탑 20 진입 2026-01-14 11:51:07

- "대형병원일수록 AI 판독 효율성 커"…제이엘케이 '부각' 2026-01-13 11:57:03

정책 기사

- 약가제도 개편 속 치료제 급여 논의기구 재구성 본격화 2026-01-15 05:10:00

- 제네릭 약가 개편 앞두고 정면 충돌…정부·산업계 온도차 2026-01-14 20:40:33

- 복지부-중소벤처기업부, 약사법 개정안 관련 공동간담회 개최 2026-01-14 15:43:25

- 권역외상센터 6700억원 투자…예상 사망률, 30.5%→9.1% 감소 2026-01-14 11:51:26

- '의약품→의료기기' 미국 관세 압박, 다음 타깃은 어디로 2026-01-14 05:30:00

정책 기사

많이 읽은 뉴스

그 밖의 기술적 방법을 이용하여 무단으로 수집되는 것을 거부하며,

이를 위반할 시에는 정보통신망법에 의해 형사 처벌될 수 있습니다.

/NewsMain.jpg)

/NewsMain.jpg)

/NewsMain.jpg)

- 최신순

- 추천순

댓글운영규칙ex) medi****** 아이디 앞 네자리 표기 이외 * 처리

댓글 삭제기준 다음의 경우 사전 통보없이 삭제하고 아이디 이용정지 또는 영구 가입이 제한될 수 있습니다.

1. 저작권・인격권 등 타인의 권리를 침해하는 경우

2. 상용프로그램의 등록과 게재, 배포를 안내하는 게시물

3. 타인 또는 제3자의 저작권 및 기타 권리를 침해한 내용을 담은 게시물

4. 욕설 및 비방, 음란성 댓글